1.安装docker

1.1 windows安装docker

打开docker官网

在cmd里查看docker版本,验证docker是否安装成功

docker-compose –version

1.2 Linux安装docker

Linux(mac,cenros,debian等)用户直接使用以下两个命令安装即可

yum install -y docker

yum install -y docker-compose

2.安装Dify

2.1 git获取Dify源代码

官网: https://github.com/langgenius/Dify

git clone https://github.com/langgenius/Dify.git

不是很建议通过直接下载zip文件的方式去获取,这样之后在升级Dify时会有点麻烦。

2.2 使用docker安装Dify

-

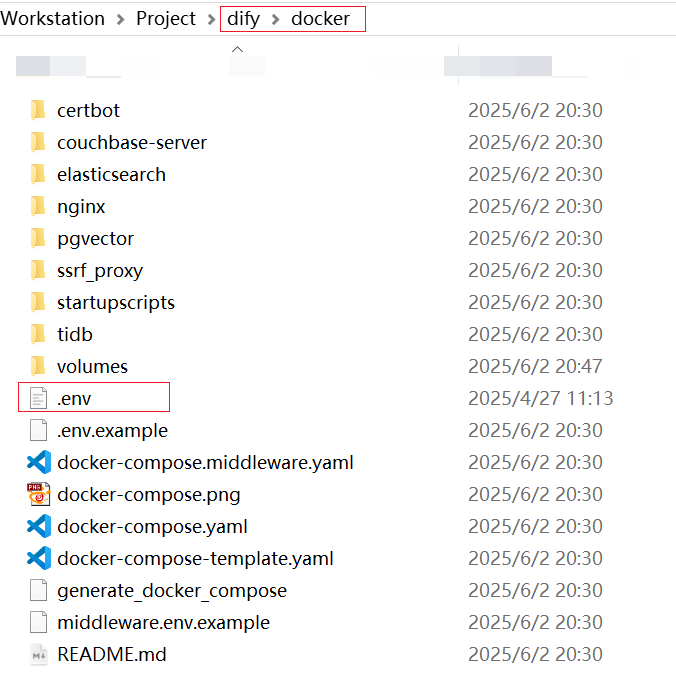

找到docker文件夹下的.env.example文件,复制一份且修改名称为.env

-

进入

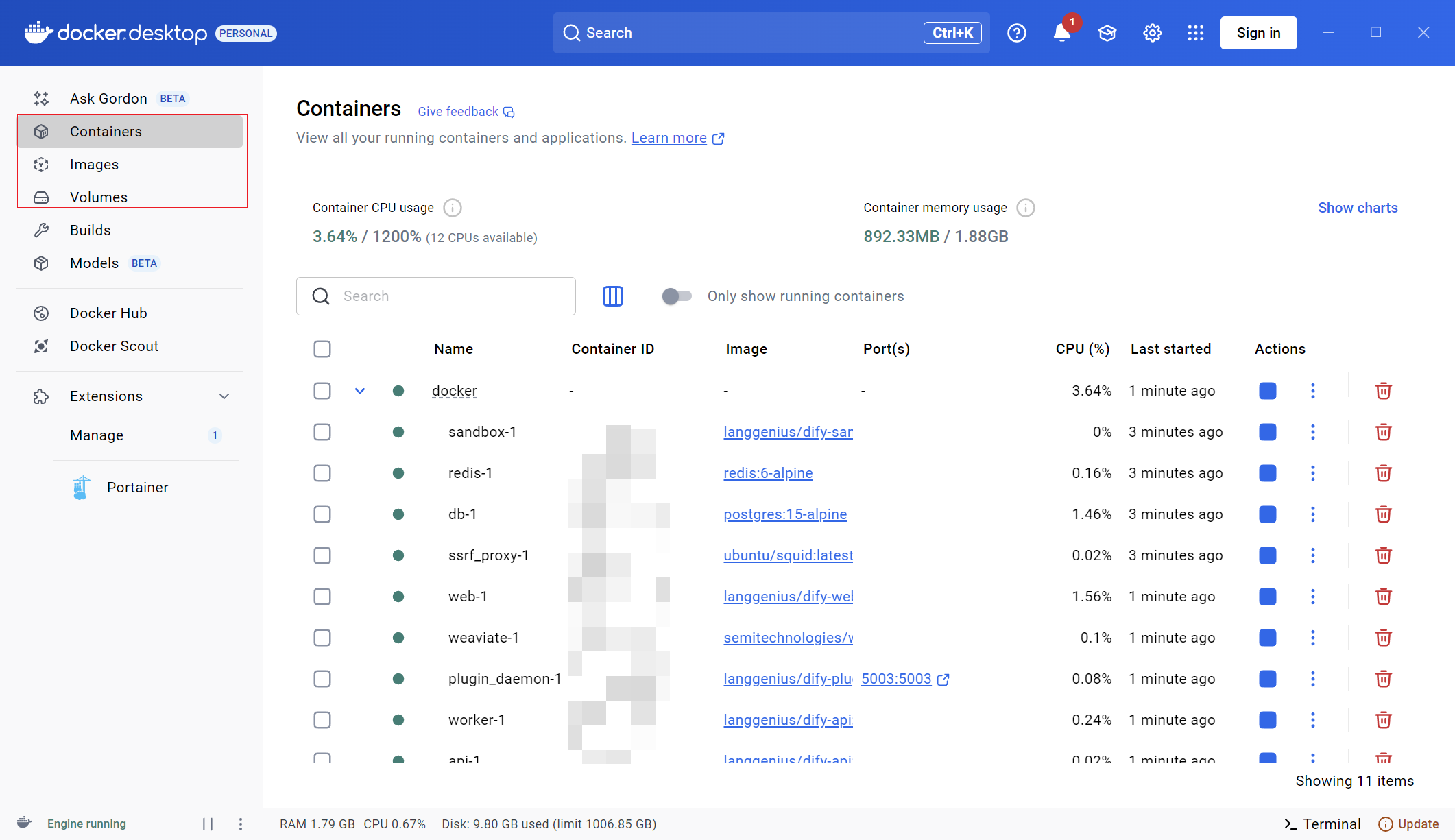

docker-compose.yaml所在文件夹的终端中,运行命令:docker compose up -d。这时候docker会按照docker-compose.yaml里的配置去自动地安装Dify。大多数情况下我们不需要去关乎docker-compose.yaml的参数和细节,我们只需要等待它执行操作即可。 -

安装成功之后,我们回到docker desktop界面中,可以看到多出一些新安装的镜像和容器,这就是Dify,且正在运行,

-

2.3 访问Dify页面

通过访问 http://127.0.0.1/apps 进入到Dify的网页端页面。

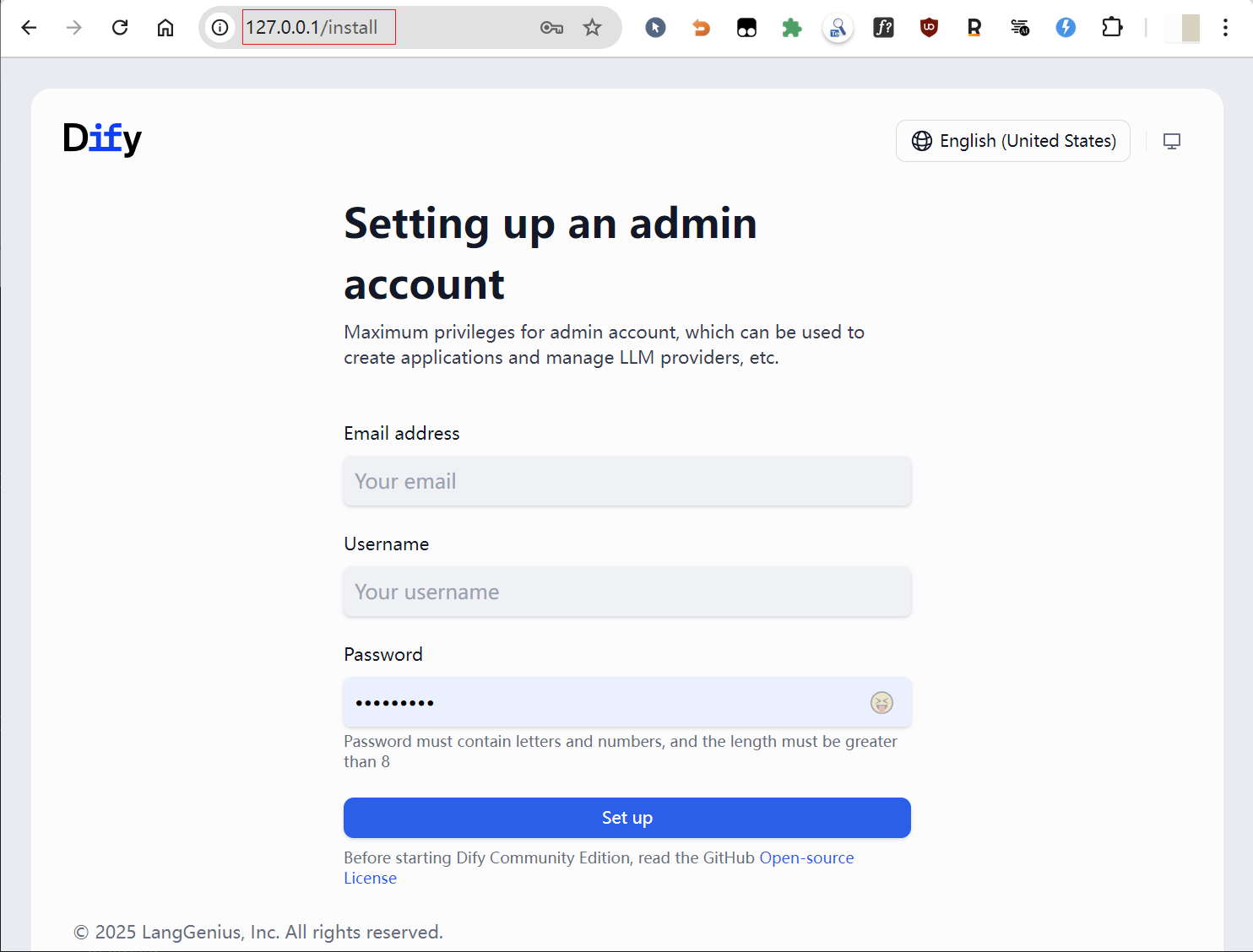

2.4 设置账号密码

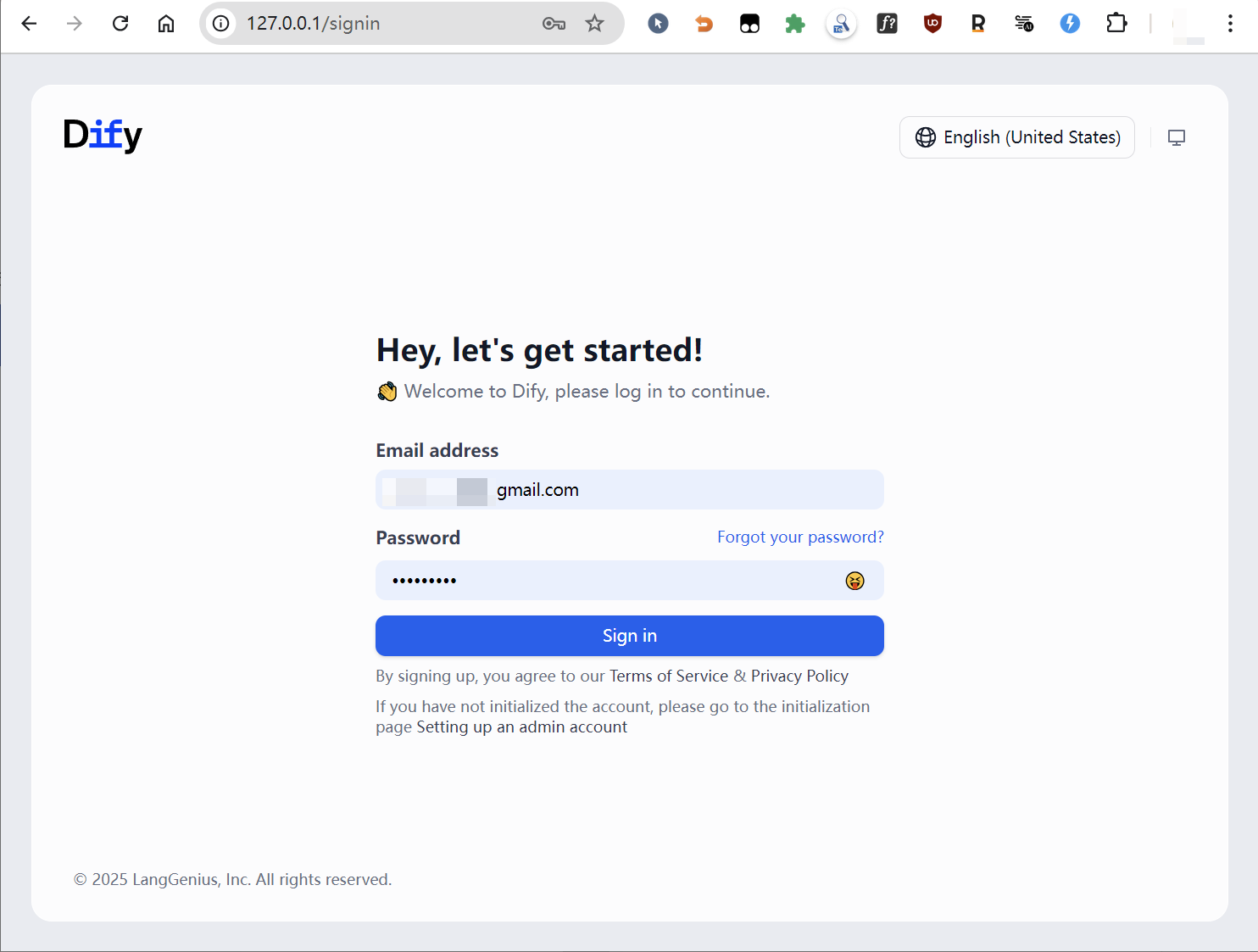

2.5 登录账号

2.6 得到工作界面

3.配置本地大模型

为什么要配制本地的大模型?我知道现在各大公司提供了免费的网页版大模型应用,比如Gemini,ChatGPT,但是这种使用方式不方便集成到Dify的工作流里面。

而如果我们去买OpenAI的API,在经济上不划算,所以部署本地的大模型是一个经济且务实的方案。像Mistral,Deepseek R1,Qwen,Gemma,Phi等开源的大模型,都是很好的选择。

3.1 安装Ollama

-

访问官网https://ollama.com/ 直接下载安装包安装即可

-

ollama run deepseek-r1:14b安装大模型 -

通过

ollama list查看已经安装了哪些大模型

3.2 在Dify中配置本地大模型

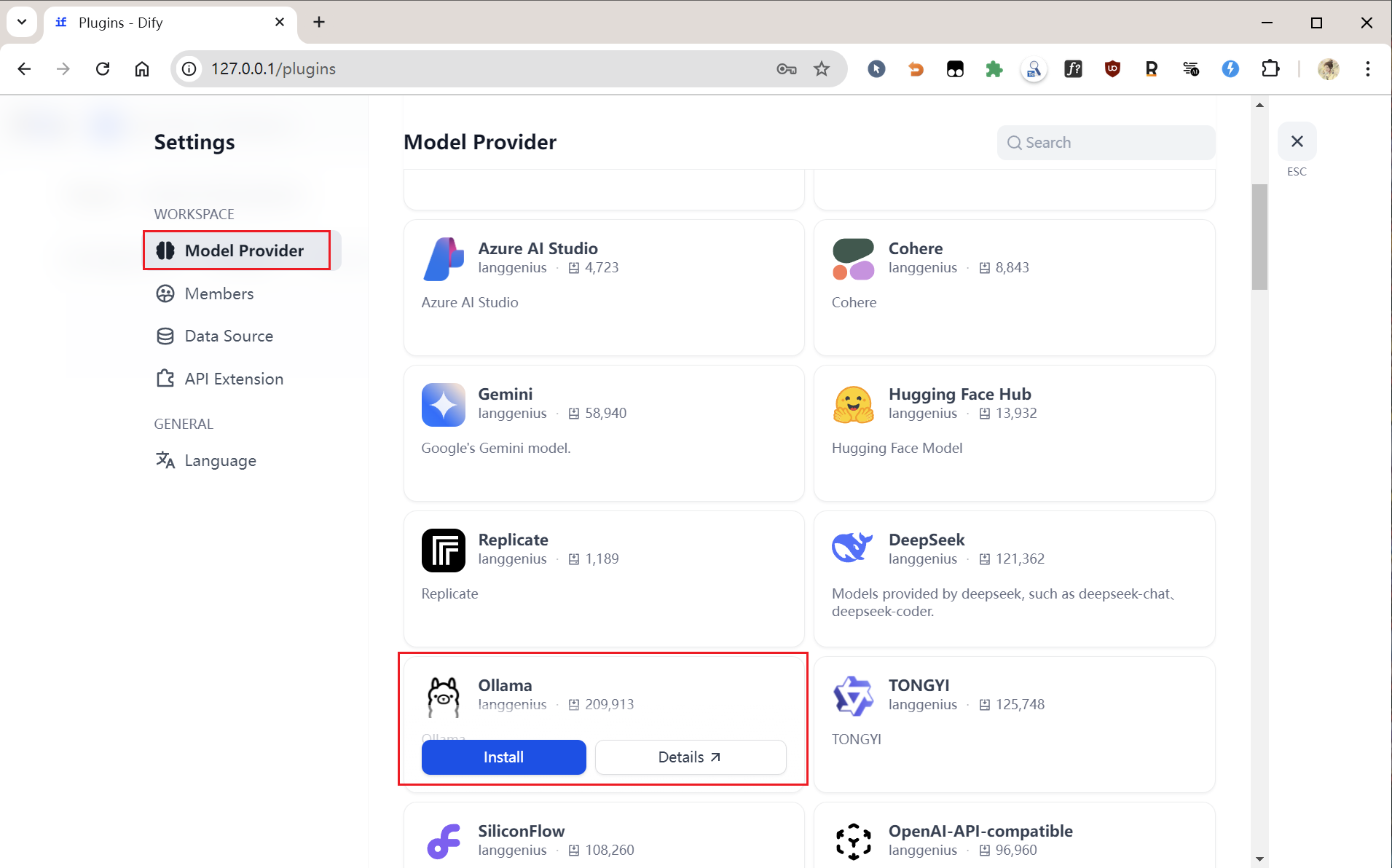

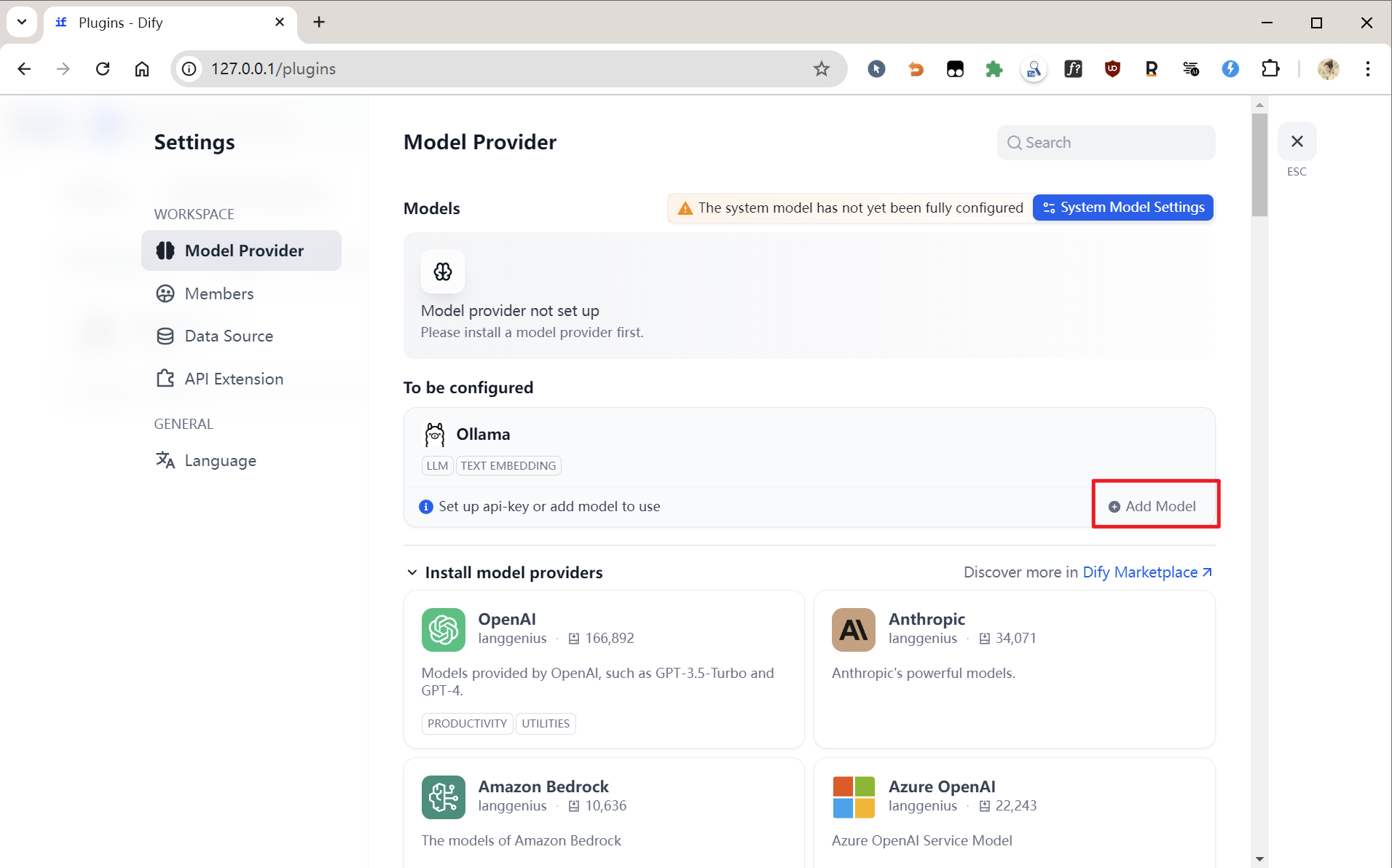

进入“设置”页面,点击“Model Provider”,找到你希望使用的大模型,我这里是Ollama,点击“安装”。

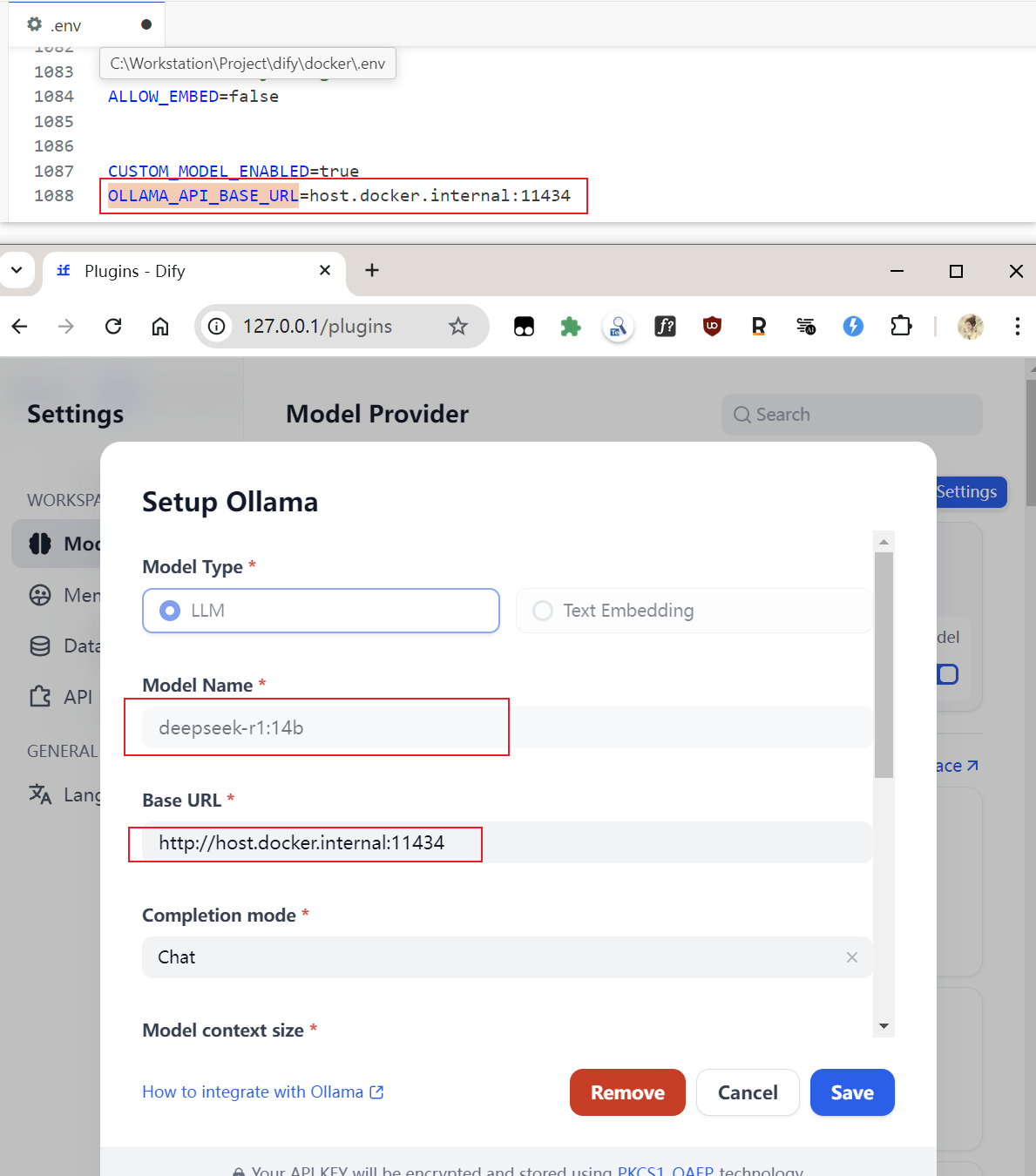

如果Dify是通过部署的话,在基础URL中填入即可,如果是其他方式部署的Dify,可以参考帮助文档:https://docs.Dify.ai/zh-hans/development/models-integration/ollama。

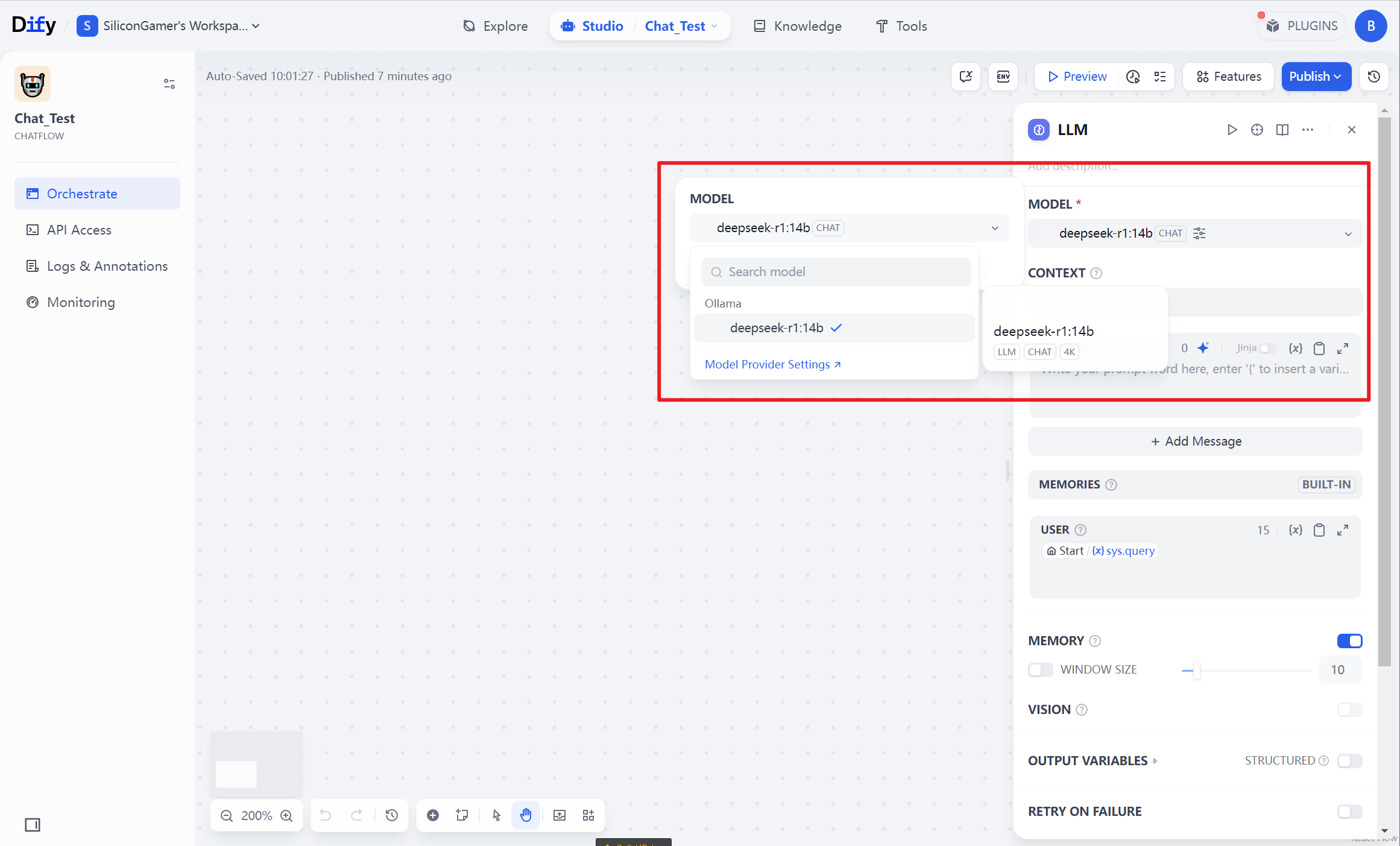

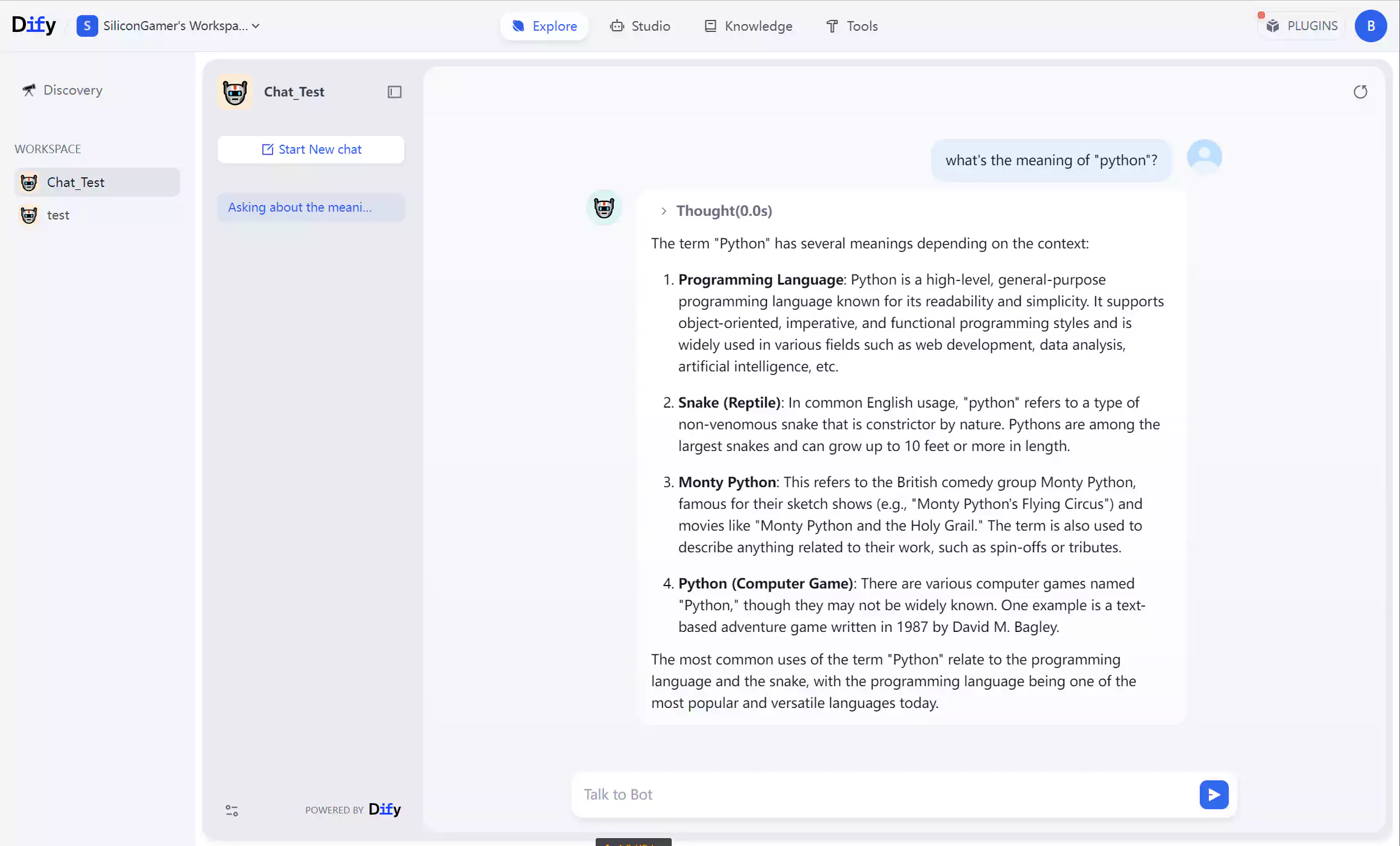

3.3 创建一个聊天Agent

3.4 在聊天Agent中提问

可以看到Dify调用了本地的大模型

4.Dify的能力有哪些?

4.1 可视化开发与编排

-

无代码 Prompt 工程

-

通过拖拽式界面设计 AI 工作流程(如对话逻辑、数据处理),支持实时调试 Prompt 并预览效果。

-

内置提示词优化工具,支持少样本学习(Few-shot Learning),提升模型输出质量。

-

-

多模型灵活切换

-

集成主流商业模型(如 GPT-4、Claude 3.5)及开源模型(Llama 3、Mistral),支持 48 小时内快速接入新模型。

-

允许私有化部署,连接本地或专属云环境中的模型。

-

4.2 智能体(Agent)与自动化

-

复杂任务处理

-

支持任务分解、推理思考、工具调用(ReAct 框架),例如自动生成报告、设计 Logo 或旅程规划。

-

-

工具生态扩展

-

内置 50+ 工具(如 Google 搜索、DALL·E 绘图、Wolfram 计算),支持自定义 API 工具(兼容 OpenAPI/Swagger 规范)。

-

-

多模态能力

-

支持文本、图像、代码生成,结合多工具协同(如用 ChatGPT 写文案 + Stable Diffusion 配图)。

-

4.3 知识库与检索增强(RAG)

-

多源数据整合

-

支持上传 PDF/PPT/DOC 等文档,自动分块、清理非结构化数据,建立向量索引。

-

-

智能检索优化

-

提供混合搜索(向量+全文)、重排序(Rerank)模型,精准定位知识片段并显示引用来源。

-

-

外部数据同步

-

支持同步 Notion 文档、网页内容至知识库,实现动态更新。

-

4.4 工作流引擎

-

复杂流程编排

-

通过节点化设计(如 LLM 调用、条件分支、HTTP 请求)构建多步骤任务链,例如:用户提问 → 知识库检索 → 生成回答 → 自动翻译 → 邮件发送。

-

-

两类工作流模式

-

Chatflow:面向多轮对话场景(如客服),支持记忆功能。

-

Workflow:面向批处理任务(如数据分析、邮件自动化),单向生成结果。

-

4.5 企业级部署与运维

-

灵活部署选项

-

支持 SaaS 云服务、私有化部署(Docker/Kubernetes),适配金融、医疗等敏感行业。

-

-

团队协作与安全

-

提供细粒度权限管理(如“仅调试提示词”)、数据隔离、审计日志。

-

-

性能监控与优化

-

实时追踪响应速度、调用次数,支持标注错误答案以迭代模型。

-

4.6 应用场景覆盖

Dify 适用于多领域快速构建 AI 原生应用:

-

智能客服:基于知识库的 7×24 小时问答,提升满意度。

-

内容创作:自动生成营销文案、周报、短视频脚本。

-

数据分析:用自然语言查询数据库(例:“上月销售额最高的产品?”)。

-

教育/医疗:个性化学习助手、智能问诊系统。

4.7 开发者友好特性

-

API 优先设计:所有功能提供 RESTful API,便于二次集成。

-

开箱即用 WebApp:内置模板支持快速发布,降低前端开发成本。

-

成本优化:按需调用模型,免费版支持 GPT-3.5,企业版可混合采购算力。

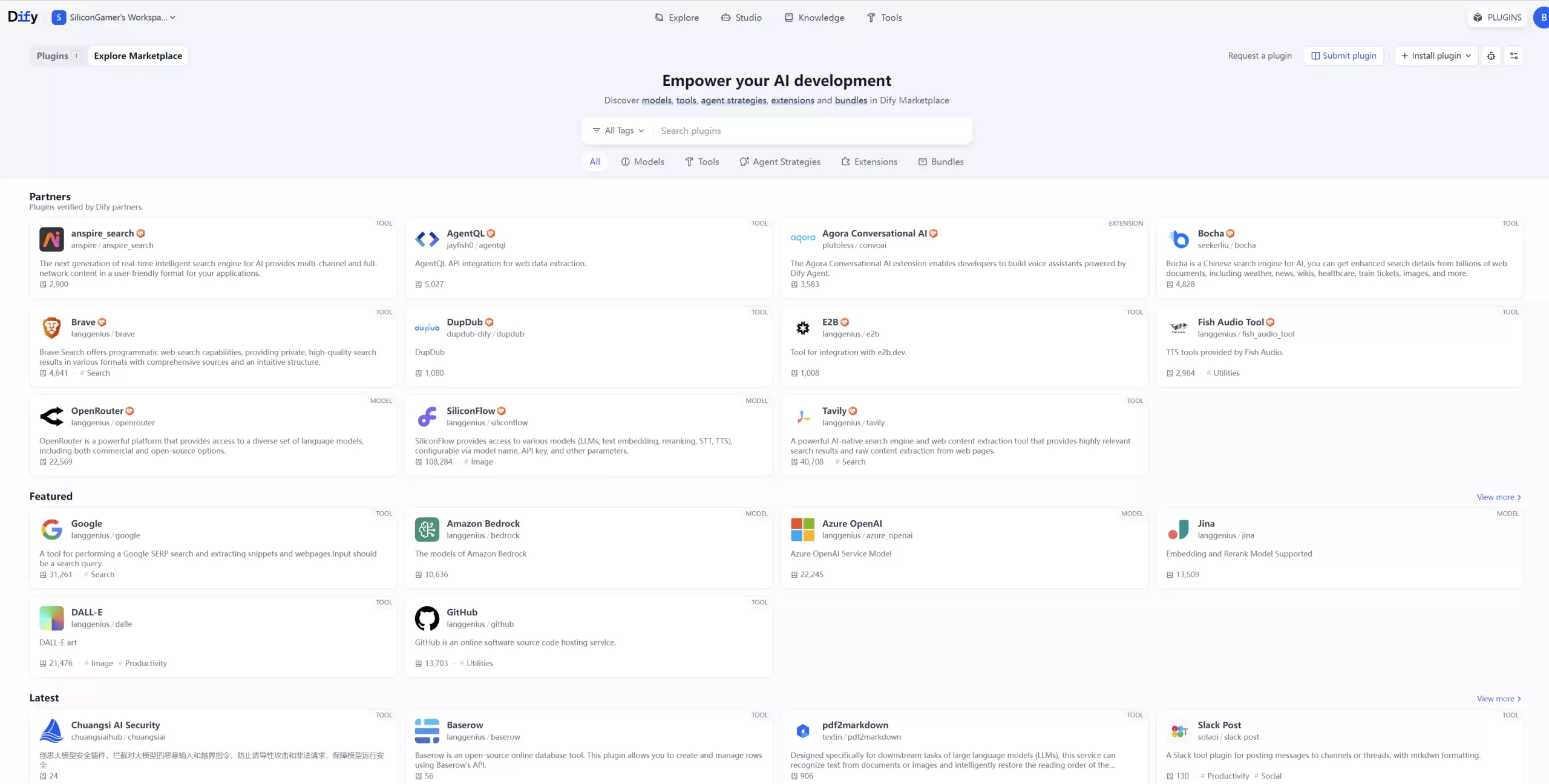

4.8 丰富的插件系统

4.9 总结

Dify 的核心价值在于通过 模块化设计 和 可视化操作,将 LLM 应用开发简化为“乐高式搭建”,同时提供企业级的运维能力。无论是开发者快速验证原型,还是企业部署复杂 AI 系统,均可通过灵活组合上述能力实现。

5.体验到Dify和ChatGPT的区别了吗?

ChatGPT很多时候只能作为一个“我问你答”式的聊天机器人,而Dify更像是一个工具箱,聊天机器人只是这个工具箱里面的一个工具。

6.快去体验Dify

我相信很多人可能在某些论坛或者科技新闻上看到过Dify这个字眼,想去体验它,又担心“Dify是一种高科技,而自己不懂编程,不懂技术” 而迟迟没有去体验。

我以过来人的角度来讲两点,第一,Dify的部署很简单,不需要你具备什么编程能力,当然,有的话更好,没的话也不影响使用。第二Dify不是万能的,他不一定符合你的预期,但是也有可能刚好能实现的你的需求。总之,只有自己亲自体验,才能知道具体是什么样子。